¿Quién revisa mi modelo? Cómo aplicar revisión por pares a proyectos de Data Science

“Más ven cuatro ojos que dos”. Este aforismo tradicional del refranero castellano, también existente en otros idiomas, nos recuerda que son más convenientes aquellas decisiones tomadas por varias personas, frente a las que se sustentan en una única opinión. Una fase crítica en el ámbito de la investigación académica se basa también en esta idea. Se trata del proceso de revisión por pares (peer review, en inglés) que consiste en la evaluación de la idoneidad de un manuscrito para su publicación. Este proceso se lleva a cabo por expertos y expertas en la materia y cumple la función de garantizar estándares de calidad, mejorar el rendimiento y proporcionar credibilidad.

La aplicación de técnicas de ciencia de datos e inteligencia artificial en la industria presenta muchas similitudes con el ámbito académico, dado que parte del trabajo se basa en la experimentación. En BBVA AI Factory somos más de 150 profesionales en campos como ciencia de datos, ingeniería, arquitectura de datos y especialistas de negocio. Los proyectos que desarrollamos son de diversa naturaleza, entre los que se incluyen proyectos de procesamiento de lenguaje natural (NLP por sus siglas en inglés), motores de predicción y optimización de alertas o sistemas de detección de fraude. Con el objetivo de mejorar la calidad, hacer sistemas más robustos y llevar a cabo una auditoría interna, hemos desarrollado una metodología inspirada en la revisión por pares del mundo académico.

Esta metodología cumple también un segundo objetivo: favorecer la transferencia de conocimiento y la participación de una manera más activa en diferentes proyectos, pero sin llegar a formar parte del desarrollo en el día a día. El diseño de esta metodología se ha llevado a cabo como un proyecto transversal y colaborativo, siguiendo varias etapas que os contamos a continuación.

En una primera fase, formamos un grupo de trabajo en el que personas de diferentes equipos y niveles de experiencia definieron los puntos iniciales de una metodología de revisión que cubriera los requisitos básicos de nuestros proyectos. No se partía de cero; nos inspiramos tanto en grandes empresas tecnológicas que han trabajado en propuestas similares – por ejemplo, auditoría de sistemas basados en inteligencia artificial1 2 -, como en científicos/as de datos que compartían su experiencia online3 o o piezas de opinión no técnicas4 5. La combinación de estos materiales y nuestra experiencia en proyectos de ciencia de datos en BBVA dio como resultado una primera versión de metodología de revisión por pares.

En una segunda fase, el proceso se abrió a contribuciones de los/as científicos/as de datos de la AI Factory, recogiendo así un feedback valioso que nos permitió refinar aún más la metodología a nuestras necesidades y desarrollar la metodología de forma colaborativa y participativa para que todos lo sintiéramos como nuestro.

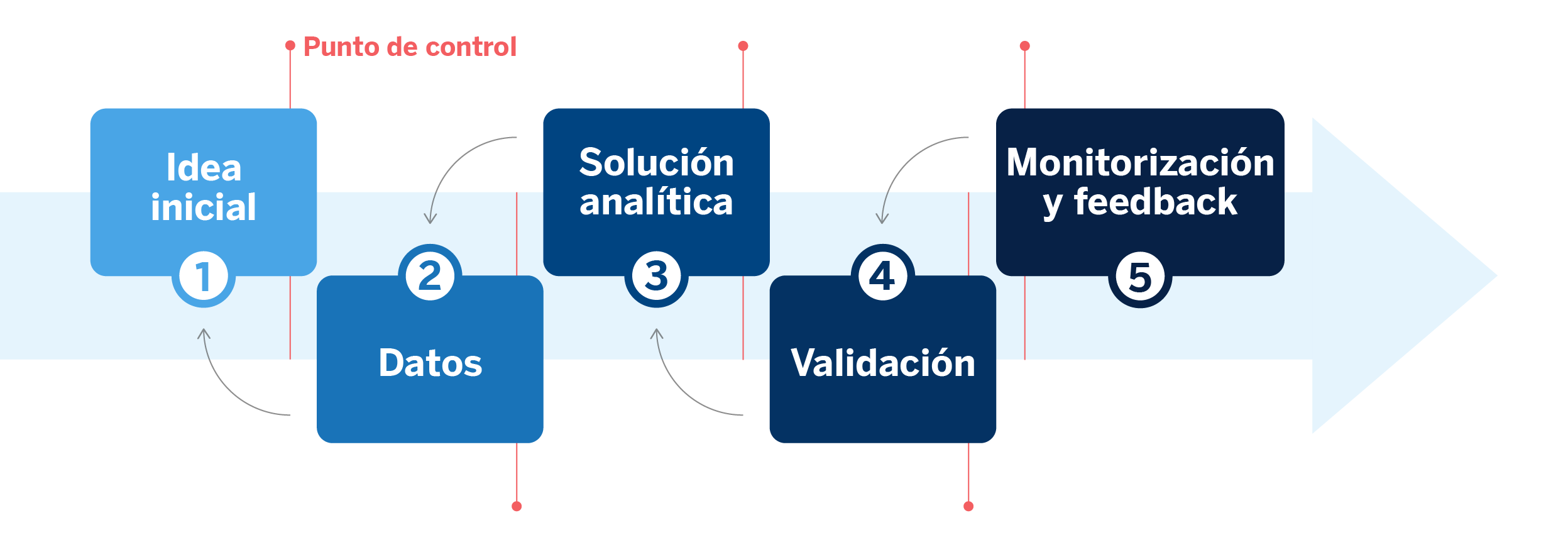

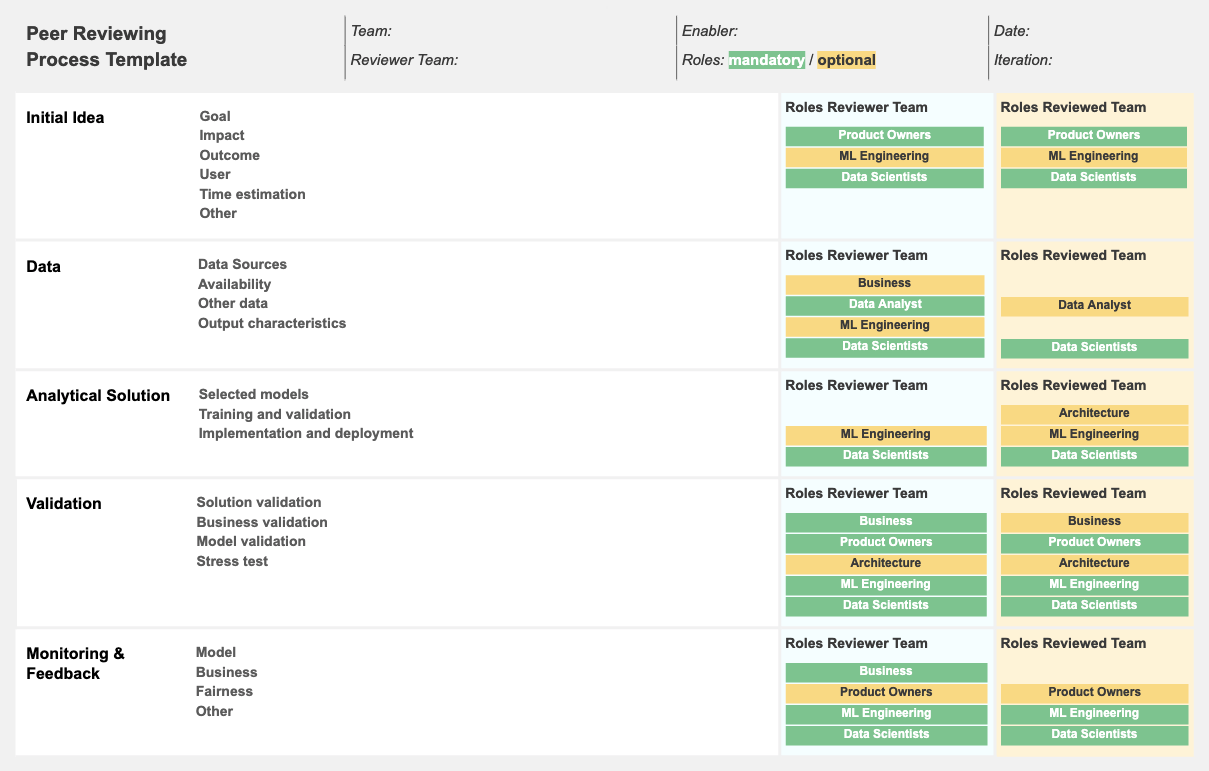

Con este trabajo obtuvimos un sistema flexible y modificable que a lo largo de los próximos meses se aplicará a todos los proyectos de la AI Factory. Este proceso divide todo proyecto de ciencia de datos en cinco fases: 1) Idea inicial, en la que se analiza el objetivo, alcance y viabilidad del proyecto; 2) Datos, que se centra en la información de entrada y salida necesaria para construir la solución; 3) Solución analítica, que cubre cada una de las iteraciones del proceso de desarrollo del modelo a partir de las features obtenidas en la fase anterior; 4) Validación, que se ocupa de ratificar la solución mediante los KPIs de negocio y las métricas utilizadas sobre los conjuntos de train, validación y test; y 5) Monitorización, en la que se pretende determinar qué se quiere monitorizar una vez la solución esté en producción desde diferentes perspectivas: stakeholders y científicos/as de datos.

Una vez establecidas las fases, tuvimos que definir cómo se iba a llevar a cabo el proceso de revisión por pares. Al inicio de un proyecto se designa un equipo revisor, liderado por un/a científico/a de datos Senior, y formado por un mínimo de dos personas. Este equipo se reúne periódicamente con el equipo revisado, quien aporta la documentación necesaria para que se entienda la totalidad de las decisiones tomadas a lo largo de las cinco fases.

Estos puntos de control periódicos se realizan obligatoriamente al finalizar las fases uno, dos, tres y cuatro, y al inicio de la fase cinco, para asegurar que todo sea correcto antes de la puesta en producción. Adicionalmente, y para hacer el proceso flexible a la complejidad de los distintos proyectos, se pueden organizar otras revisiones bajo demanda en medio de las distintas fases. Durante dichas reuniones, el equipo revisor plantea las preguntas que considere necesarias y da feedback constructivo al equipo revisado. En caso de una evaluación positiva, se pasa a la siguiente fase y se rellena un documento one-pager que refleja el contenido y las conclusiones de las sesiones.

Al finalizar el proceso se realiza un último punto de control para verificar que la documentación sea correcta y autoexplicativa, decidir los siguientes pasos del proyecto y poder hacer una retrospectiva del proceso completo.

La implantación de la metodología se está realizando gradualmente dentro de BBVA AI Factory, comenzando con tres proyectos piloto totalmente diferentes, que cubren los diferentes casos de uso con los que trabajamos: por ejemplo, uno de los proyectos en revisión está orientado a construir mejores embeddings de transacciones con tarjeta y otro a la utilización de grafos en escenarios de análisis de patrones financieros. Esto nos ha servido para aplicar la revisión de pares a la metodología en sí misma, recopilando comentarios de los equipos revisados y revisores, e identificando puntos de mejora para iteraciones futuras de la metodología.

Además pretendemos que próximas versiones de la metodología incluyan pautas que nos ayuden a mejorar nuestra capacidad de detectar sesgos y así evitar potenciales discriminaciones. De esta forma dispondremos de una herramienta que permita a los miembros de los equipos revisado y revisor cuestionar la equidad del proyecto y plantear mejoras que garanticen que los algoritmos detrás de nuestros sistemas sean imparciales e inclusivos. Queremos que, por diseño, nuestras soluciones sean colaborativas, robustas y justas; preparándonos para la banca del futuro.

Referencias

- Closing the AI accountability gap: defining an end-to-end framework for internal algorithmic auditing, FAccT 2020 ↩︎

- The value of a shared understanding of AI models, Google Model Cards ↩︎

- Peer Reviewing Data Science Projects, Shay Palacy (2015) ↩︎

- A ‘Red Team’ Exercise Would Strengthen Climate Science ↩︎

- Why, How, What, In That Order: Using The Golden Circle To Improve Your Business & Yourself ↩︎