Innovación

La Equidad en Machine Learning se Vuelve “Mainstream”

10/08/2018

Las consideraciones de equidad o "fairness" en el desarrollo de soluciones basadas en ML están cobrando fuerza como aspecto clave de la inteligencia artificial y la modelación de comportamientos sociales.

Las consideraciones de equidad o “fairness” en el desarrollo de soluciones basadas en Machine Learning (aprendizaje automático) están cobrando fuerza como aspecto clave de la inteligencia artificial y la modelación de comportamientos sociales. Esta semana, el Harvard Business Review publicó un artículo escrito por los responsables de un proyecto de análisis en sanidad que utiliza Machine Learning para detectar a las personas con propensión a tener una enfermedad cardiovascular.

Los investigadores detrás del Stroke Belt Project han detallado algunos consejos útiles para aquellos que quieren evitar los prejuicios sociodemográficos, raciales o de cualquier otro tipo introducidos por aquellos que preparan los datos, construyen el modelo o optimizan los resultados.

En un esfuerzo por promover el concepto “Fairness by Design”, que desde BBVA Data & Analytics tratamos de tener siempre presente a la hora de modelar y muestrear datos, prescriben algunos consejos:

- Unir científicos de datos con expertos en ciencias sociales para introducir una perspectiva humanista a los datos y a la solución a implementar.

- Anotar los datos con precaución. Hacer que los responsables de anotar los datos que van a alimentar un modelo de aprendizaje de la máquina sean conscientes de sus posibles sesgos.

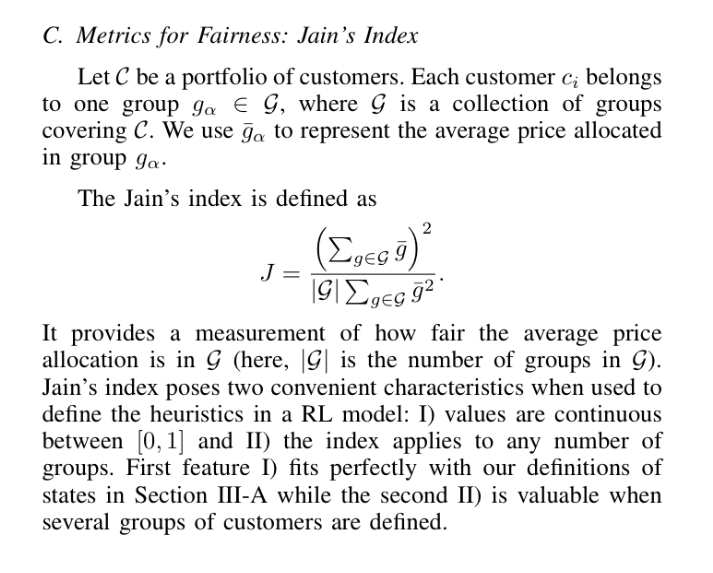

- Medir la equidad. Utilizando métricas para medir la imparcialidad que ayuden a corregir el sesgo.

- No concentrarse sólo en la representatividad.Una vez que se hayan establecido las medidas de equidad, encontrar un equilibrio entre la representatividad de los casos futuros y la infrarrepresentación de las minorías.

- Tener en cuenta la eliminación del sesgo y, si es necesario, evitar la categorización basada principalmente en variables sociodemográficas.